Rose La Prairie es responsable de grupo de productos de la Búsqueda de Google y responsable de producto de Rodea para Buscar. Se encarga de desarrollar nuevas formas para que las personas exploren el mundo que nos rodea. En este artículo conversa con Lou Wang, cofundador de Google Lens y director sénior, que dirige los productos de IA multimodal de la Búsqueda de Google, como Lens, Rodea para Buscar y la Búsqueda por voz.

Imagina conocer los secretos de la búsqueda visual de la mano de alguien que no solo ayudó a crearla, sino que la usa a diario.

Te presentamos a Lou Wang.

Es uno de los cofundadores de Google Lens, una herramienta que usan cada mes más de 1500 millones de personas para buscar información sobre lo que ven. De hecho, el uso de Lens ha crecido un 65 % interanual1, con más de 100.000 millones de búsquedas visuales en lo que va de año.2

Pero Wang no es solo un arquitecto de esta tecnología, sino que también se autoproclama como un usuario avanzado. Hace poco, usó Lens con su hijo de seis años para identificar una cría de zarigüeya que encontraron en su jardín.

Ahora, comparte su experiencia personal con la búsqueda visual, así como de las tendencias globales y de las estrategias indispensables para que los profesionales del marketing conecten con las audiencias en un mundo cada vez más visual.

Rose La Prairie (RLP): Como cofundador de Google Lens, has estado en primera línea de la revolución en la forma en que interactuamos con la información. Cuando se lanzó Lens en 2017, ¿cuál fue el momento “eureka” en el que descubriste el inmenso potencial de la búsqueda visual?

Lou Wang (LW): La tecnología de la búsqueda visual estaba en sus inicios cuando empezamos a trabajar en Lens. Existían modelos de aprendizaje automático personalizados para ayudar a identificar animales (como razas de perros y gatos) y plantas, pero, en general, la búsqueda visual aún no era muy fiable.

Paradójicamente, uno de los momentos “eureka” se produjo cuando nos dimos cuenta de que podíamos desarrollar productos de búsqueda visual centrándonos en el texto. El texto está en todas partes: en carteles, documentos, menús… La capacidad de Google para comprender texto estaba más avanzada que la de comprender objetos aleatorios. En 2016, llegamos a tener un prototipo con el que la gente podía fotografiar un texto, tocarlo en la pantalla y obtener resultados de búsqueda. Por ejemplo, podían obtener más información sobre un grupo de música que aparecía en un cartel o sobre un plato de pasta que estaban viendo en un menú.

Esta idea nos permitió crear algo realmente útil con bastante rapidez. Desde entonces, la tecnología de IA ha mejorado enormemente y hemos podido incorporar cada vez más funciones en Lens. A la gente les sigue encantando usar Lens para el texto, pero ahora pueden buscar visualmente casi cualquier cosa. Además, incorporamos constantemente nuevas funciones basadas en IA para que Lens sea aún más eficaz a la hora de responder a las consultas de búsqueda visual de los usuarios.

RLP: Ha sido fascinante ver la evolución desde el texto hasta las enormes capacidades que Google Lens ofrece hoy en día. ¿Ha habido alguna forma especialmente memorable en la que lo hayas usado tú mismo?

LW: Una de las cosas más geniales fue ver a mi hijo aprender a usar Google Lens antes incluso de cumplir dos años. Si tienes hijos, sabrás que señalan todo lo que ven y preguntan “¿Qué es eso?”. Los niños son visuales por naturaleza.

Mi hijo tiene ahora seis años y ya es un usuario avanzado. Va por la casa haciendo preguntas sobre todo lo que ve.

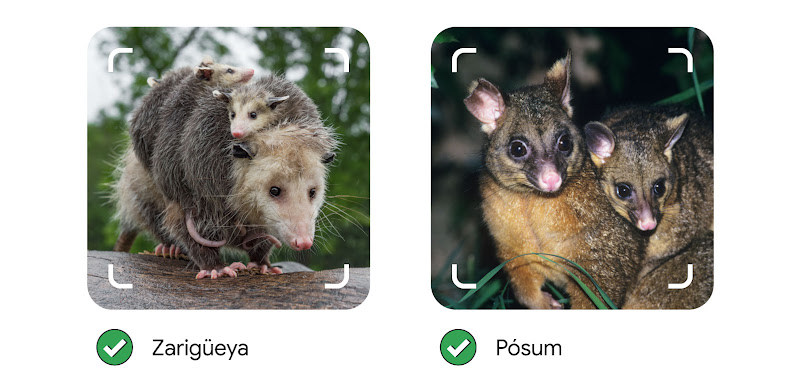

Hace poco vivimos un momento divertido cuando vimos un animal extraño en nuestro jardín. Utilizamos Google Lens para descubrir que se trataba de una cría de zarigüeya. Después, usando las capacidades de búsqueda multimodal de Lens, hicimos preguntas como qué tamaño alcanza este animal. Al parecer, hasta 60 cm, ¡lo que da bastante miedo!

También descubrimos que las zarigüeyas viven en Norteamérica, mientras que los pósums viven en Australia.

Pero mi hijo no es el único que usa Google Lens. A menudo oigo hablar de familias que, durante su paseo por el barrio, ven flores y se preguntan qué son. Lens les ofrece una forma natural de hacer esas preguntas.

RLP: Como responsable de producto de Rodea para Buscar, el año pasado me sentí entusiasmada al lanzar esta forma intuitiva y basada en gestos de explorar el mundo, posible gracias a la labor pionera que desarrollaste con Google Lens. ¿De qué forma ha cambiado esta función las reglas del juego de la búsqueda visual?

LW: Rodea para Buscar ha supuesto un punto de inflexión. A menudo, los usuarios piensan en Google Lens como en un instrumento que permite hacer una foto con la cámara para plantear una pregunta. La función Rodea para Buscar va un paso más allá, ya que permite rodear una parte de la imagen o tocar un objeto que aparezca en ella. Los usuarios pueden incluso rodear capturas de pantalla o publicaciones en redes sociales sin cambiar de aplicación en ningún momento.

En el momento en que alguien ve algo y le surge una pregunta, puede plantearla al instante. Esta facilidad de uso es increíblemente potente y a los usuarios les encanta.

Ver el vídeo

Ha sido especialmente útil para las compras. Las personas se inspiran constantemente en lo que ven en YouTube y en las redes sociales. Un caso de uso habitual es ver online a un influencer que lleva puesto un conjunto de moda genial y querer saber más. Rodea para Buscar hace que este proceso sea sencillo y fluido. Los usuarios pueden “rodear con un círculo” una prenda de vestir para encontrarla, e incluso buscar estilos similares en su rango de precios preferido en las tiendas cercanas.

RLP: Es fantástico saber que los usuarios usan la búsqueda visual para hacer compras. ¿Qué otros casos de uso habituales habéis observado?

LW: En Europa y en África, las compras son sin duda el caso de uso estrella, sobre todo para los artículos que son difíciles de describir con palabras, como ropa, productos para el hogar y accesorios.

Otro ámbito en el que registramos un amplio uso es la educación. En países como la India e Indonesia, los deberes escolares se asignan a menudo en inglés, por lo que los alumnos usan Google Lens para traducirlos a idiomas como el hindi y comprender mejor las preguntas. También pueden recibir ayuda con los deberes directamente desde Lens y desde la Búsqueda. Este caso de uso también está creciendo en otros mercados.

Otra tendencia interesante que hemos observado es que las consultas de Google Lens relativas al mundo natural, como animales y plantas, son especialmente populares en Alemania y Japón. ¡Parece que en esos países hay un aprecio especial por la naturaleza!

Y estamos viendo que los usuarios usan cada vez más la búsqueda múltiple en Lens para expresar intenciones más complejas. No se limitan, por ejemplo, a compartir una foto de una hoja, sino que la acompañan de una pregunta, como "¿Cómo cuido esta planta?”.

RLP: Desde el punto de vista empresarial, ¿cómo pueden los profesionales del marketing sacar el máximo partido a la búsqueda visual?

LW: Para mejorar la visibilidad y el descubrimiento de productos, es importante que las marcas tengan muchas imágenes de buena calidad, con metadatos precisos y específicos que describan lo que contienen.

Por ejemplo, si vendes un vestido, proporciona imágenes que muestren el artículo desde varios ángulos, tanto solo como en modelos con diferentes tipos de cuerpo. Los propios usuarios también hacen fotos desde distintos ángulos, por lo que valoran esa variedad visual y ese contexto. Y, como vendedor, esta variedad aumenta la probabilidad de que las imágenes de vestidos destaquen en los resultados de búsqueda.

Otro aspecto, especialmente relevante en el sector de la moda, es que las temporadas cambian muy rápido. Los artículos vendidos hace seis meses podrían haber dejado de estar disponibles. Y, sin embargo, muchas personas siguen tratando de encontrarlos. Tal vez hayan visto a alguien en televisión con un vestido concreto y quieran saber cuál es y dónde se puede comprar.

Si un producto desaparece por completo de Internet, ya no podemos responder a esa pregunta. Resulta útil mantener online los productos y las imágenes de temporadas anteriores para que sean accesibles y añadir información sobre una versión de “nueva temporada” o sugerir artículos similares en stock. Se trata de una oportunidad para dirigir a los clientes hacia artículos similares disponibles, aunque el original ya no lo esté.

En lo que respecta a la visibilidad y el descubrimiento de productos, es importante que las marcas tengan muchas imágenes de buena calidad, con metadatos precisos y específicos

RLP: Por último, ¿qué le depara el futuro a la búsqueda visual?

LW: El reciente anuncio de la búsqueda en directo (que estará disponible en inglés en Estados Unidos este verano), añade una forma de conversar con la Búsqueda que resulta aún más natural.

Imagina que estás mirando un cuadro y que puedes simplemente decir en voz alta: “Este estilo es muy interesante, ¿qué puedes contarme sobre él?”. Y luego, al descubrir que es un cuadro impresionista, podrías preguntar: "¿Quiénes artistas famosos representan ese estilo?”. Ese es el tipo de capacidad fluida y en tiempo real que estamos desarrollando, para que la interacción sea más sencilla esté más en sintonía con la forma en que las personas realmente piensan y exploran.

Forma parte de las nuevas experiencias impulsadas por IA que estamos incorporando a nuestros productos. Una novedad significativa ha sido la integración de las Vistas creadas con IA. Si antes podíamos mostrar una cuadrícula de imágenes visualmente similares, ahora podemos proporcionar interpretaciones más detalladas y responder a preguntas más complejas.

Otro aspecto fundamental es facilitar la búsqueda “en el momento”. La función Rodea para Buscar ha sido genial para los usuarios de Android y vamos a ampliar estas experiencias a los ordenadores. Google Lens está ahora integrado en el navegador Chrome, lo que significa que, cuando te llega la inspiración o te surge una pregunta respecto a algo que ves, tienes la posibilidad de explorarlo todo directamente allí.

Seguiremos mejorando estas experiencias para que todos los usuarios puedan satisfacer su curiosidad de la forma más natural posible. De esta forma, los usuarios pueden señalar y hacer preguntas, igual que haría un niño de dos años, para obtener la información que están buscando.